Natuurlijke taalverwerking: wat is het en waarom is het belangrijk?

Wilt u het potentieel van natuurlijke taalverwerking in uw bedrijf of volgende project ontsluiten? Hier vindt u alle informatie en bronnen die u nodig heeft om aan de slag te gaan.

Het vermogen om menselijke talen te verwerken en te genereren geeft elke computer de kracht om meer te zijn dan alleen maar een machine – omdat het barrières slechtt, de interactie tussen mens en computer vereenvoudigt, talloze mogelijkheden biedt voor nieuwe sets computersystemen en de productiviteit verhoogt.

In deze blogpost wordt de verwerking van natuurlijke taal onderzocht om te begrijpen hoe deze van nut kan zijn voor u en uw bedrijf.

Wat is natuurlijke taalverwerking?

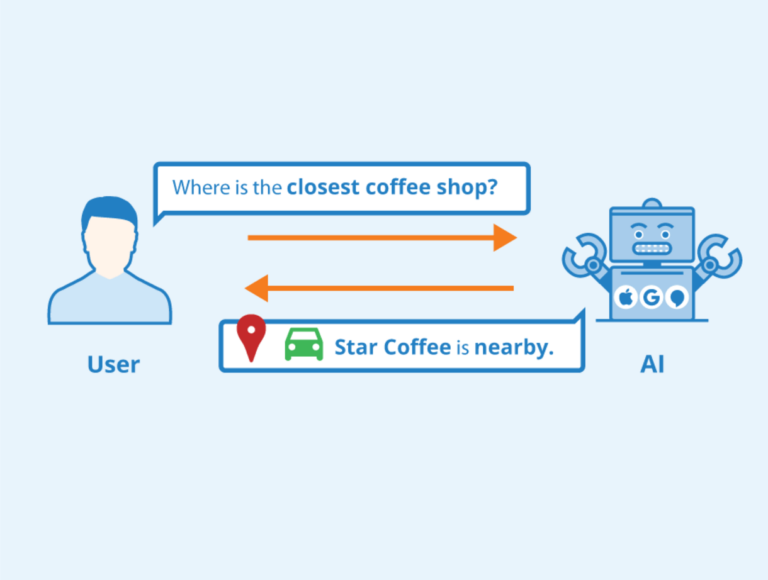

Natural Language Processing, ook wel NLP genoemd, is een deelgebied van de informatica en taalkunde. Het doel is om computers de mogelijkheid te bieden menselijke talen te begrijpen, interpreteren en genereren.

Taal vormt de kern van menselijke interacties en NLP is de brug die mensen op de meest natuurlijke manier met computers verbindt, ook via tekst, spraak en zelfs gebarentaal.

Natuurlijke taalverwerking dateert uit het begin van de jaren vijftig, met de Georgetown-IBM-experiment in 1954 vertaalde dat automatisch meer dan 60 Russische zinnen naar het Engels. De ontwikkelingen gingen door tot in het laatste deel van de eeuw, maar de meeste van die systemen maakten gebruik van handgeschreven regels.

Vanaf eind jaren tachtig echter Statistische NLP is ontstaan uit de steeds groter wordende en goedkopere verwerkingskracht. Het maakte gebruik van statistische modellen en machine learning-technieken zoals parallelle corpus om patronen, relaties en kansen uit grote datasets te ontdekken. Aan het begin van de jaren 2000 waren neurale netwerken echter de voorkeursmachinemethoden geworden vanwege hun veel betere prestaties.

Tegenwoordig worden verschillende soorten neurale netwerken gebruikt voor natuurlijke taalverwerking. Ze bevatten:

- Transformer-modellen

- BERT (Bidirectionele Encoder Representaties van Transformers)

- CNN (convolutionele neurale netwerken)

- RNN's (terugkerende neurale netwerken)

- LSTM's (Long Short-Term Memory)-netwerken.

De modellen passen verschillende taken en subtaken toe op de invoergegevens om de vereiste uitvoer te produceren, zoals het genereren van tekst, taalbegrip, spraakherkenning, vertaling, enzovoort.

Waarom is NLP belangrijk?

De toepassingen van NLP zijn enorm en blijven evolueren. Dit maakt het een belangrijke technologie voor veel industrieën en toepassingen. Hier zijn een paar voorbeelden:

- Machine vertaling: NLP wordt toegepast om met verbazingwekkende precisie en grammaticale integriteit van de ene taal naar de andere te vertalen.

- Virtuele Assistenten: Van het bieden van klantenservice tot het beantwoorden van een groot aantal vragen, het bieden van gezelschap en het uitvoeren van taken via spraakopdrachten: NLP helpt de productiviteit van werknemers te vergroten en de levenskwaliteit van velen te verbeteren.

- Tekstanalyse en samenvattingen: NLP maakt het gemakkelijker om belangrijke informatie met indrukwekkende snelheid uit grote documenten te halen. Het helpt om documenten, teksten, e-mails of webpagina's sneller samen te vatten dan welk mens dan ook.

- Sentiment analyse: Door de emoties en meningen te begrijpen die in een tekst of document worden uitgedrukt, kunnen bedrijven waardevolle informatie extraheren voor marktonderzoek, monitoring van sociale media en toekomstige marketingcampagnes.

Hoe natuurlijke taalverwerking werkt

Natuurlijke taalverwerking richt zich op het mogelijk maken van computers om menselijke taal te begrijpen en te interpreteren door de kracht van taalkunde en computerwetenschappen te combineren met behulp van verschillende technieken die kunnen variëren van op regels gebaseerde benaderingen die vertrouwen op vooraf gedefinieerde regels, tot statistische modellen die hun patronen leren uit gelabelde trainingsgegevens , en de modernere deep learning-modellen die neurale netwerken gebruiken om nog complexere patronen uit tekst te identificeren en te categoriseren.

Hoewel verschillende systemen zullen variëren in hun implementatie van NLP, is een algemeen proces met verschillende stappen als volgt:

- Voorverwerking van tekst: Dit is de eerste fase voordat al het andere werk kan beginnen. Eerst wordt de tekst opgesplitst in afzonderlijke woorden of kleinere eenheden, zoals zinsdelen die tokens worden genoemd. Dit proces zelf wordt tokenisatie genoemd en helpt bij het effectief organiseren en verwerken. Andere voorverwerkingstaken zijn onder meer kleine letters, waarbij alle tekst wordt omgezet in kleine letters voor uniformiteit, en het verwijderen van stopwoorden die weinig bijdragen aan de betekenis.

- Deel-van-spraak tagging: Deze stap omvat het toewijzen van grammaticale tags aan elk van de tokens die zijn afgeleid in stap 1 hierboven. Grammaticale tags omvatten zelfstandige naamwoorden, werkwoorden, bijvoeglijke naamwoorden en bijwoorden. Deze stap helpt bij het begrijpen van de syntactische structuur van de invoertekst.

- Erkenning van benoemde entiteiten (NER): Een benoemde entiteit omvat zaken als de namen van mensen of een plaats, het adres van een organisatie, het model van een auto, enzovoort. Deze stap omvat de identificatie en categorisering van de genoemde entiteiten in de tekst. Het doel hier is om mogelijk belangrijke informatie te extraheren die zal helpen de tekst beter te begrijpen.

- Parseren en syntaxisanalyse: Hier analyseer je de grammaticale structuur van zinnen in de tekst om de relaties tussen woorden en zinsdelen te proberen begrijpen. Het doel van deze stap is om de betekenis en context van de tekst te begrijpen.

- Sentiment analyse: Met sentimentanalyse wil je inzicht krijgen in de idee(en) die in de tekst worden uitgedrukt. Sentimenten kunnen positief, negatief of neutraal zijn en helpen een beter beeld te schetsen van de algemene houding of meningen ten aanzien van een bepaald onderwerp.

- Taalmodellering: Dit proces omvat het bouwen van statistische of machine learning-modellen die de patronen en relaties in taalgegevens vastleggen. Deze modellen maken taken mogelijk zoals het genereren van talen, automatische vertaling of het samenvatten van teksten.

- Uitgangsgeneratie: Het laatste deel is het genereren van een uitvoer voor de gebruiker. Dit is nodig voor taken zoals het vertalen van talen en het samenvatten van teksten.

Meer natuurlijke taalverwerkingstaken

Naast de hierboven genoemde processtappen worden er bij de verwerking van natuurlijke taal vaak nog veel andere taken gebruikt om de gewenste resultaten te bereiken. Hier zijn enkele van de meest populaire.

- OCR: OCR staat voor Optical Character Recognition en is een technologie die wordt gebruikt om afbeeldingen om te zetten in digitale gegevens. Als u bijvoorbeeld een factuur of kassabon moet scannen om de cijfers eruit te halen en deze in de database van uw bedrijf op te slaan, gebruikt u een softwareprogramma met OCR-mogelijkheden. De OCR-technologie heeft echter zijn beperkingen, zoals wat betreft woordnauwkeurigheid, context en semantisch begrip. Maar met de toevoeging van NLP kunnen OCR-programma's betere resultaten produceren met meer contextueel begrip, bruikbare inzichten, verbeterde nauwkeurigheid en categorisaties.

- Spraakherkenning: Van digitale transcriptiediensten tot stemassistenten en spraakgestuurde apparaten, de toepassingen van spraakherkenning zijn talrijk. Eenvoudige herkenning van audiospraak heeft echter niet veel nut zonder de toegevoegde informatie uit context- en sentimentanalyse. NLP maakt spraakherkenningstechnologie verder zeer nuttig door tekstuitvoer van audio-invoer te leveren die verder in andere machines kan worden ingevoerd voor meer productiviteit.

- Text-to-Speech: De transformatie van geschreven tekst naar hoorbare spraak, vaak gebruikt om chatbots en virtuele assistenten een mensachtige hoorbare stem te geven. Hoewel de eerste implementaties monotone stemmen hadden, moderner tekst naar spraak systemen zoals elflabs zijn zo goed geworden dat je hun output nauwelijks kunt onderscheiden van een originele stem.

- Natuurlijk taalbegrip: Dit is het proces waarbij een redelijke betekenis wordt gegeven aan elke dataset. Het begrijpen van natuurlijke taal omvat elke taak die het begrip en de interpretatie van de tekst kan verbeteren, van herkenning van benoemde entiteiten tot syntaxis- en grammatica-analyse, semantische analyse en verschillende machine learning-algoritmen.

- Natuurlijke taalgeneratie: Een van de meest bekende taken. Hier worden gegevens omgezet in woorden die ieder mens kan begrijpen door een verhaal te vertellen of dingen uit te leggen. Dit is wat chatbots gebruiken om interessante gesprekken te genereren. Een ander type natuurlijke taalgeneratie is tekst-naar-tekstgeneratie, waarbij één invoertekst wordt omgezet in een totaal andere tekst. Deze methode is te vinden in samenvattingen, vertalingen en herformuleringsbots.

- Erkende entiteitsherkenning: NER of Named Entity Recognition is een subtaak voor het extraheren van informatie die de identificatie en classificatie van items of entiteiten in vooraf gedefinieerde categorieën omvat. Daarom helpt NER de machine specifieke entiteiten, zoals een persoon, auto of plaats, uit een tekst of document te herkennen, waardoor de extractie van betekenisvolle informatie wordt verbeterd.

- Sentiment analyse: Dit is een ander deelgebied van natuurlijke taalverwerking dat probeert emoties en persoonlijke meningen uit tekstgegevens te halen en te begrijpen. Dankzij deze mogelijkheid kunnen machines beter omgaan met de complexiteit van menselijke communicatie door gevoelens als sarcasme, culturele verschillen en positieve, negatieve en neutrale gevoelens te meten. Bedrijven gebruiken het voor marktonderzoek, merkmonitoring, klantenondersteuning en analyse van sociale media.

- Toxiciteitsclassificatie: Wanneer u haatzaaiende uitlatingen op een forum of op sociale media plaatst en de moderatorbot dit automatisch markeert, wordt u betrapt door een AI-model voor toxiciteitsclassificatie. Deze systemen zijn getraind met machinaal leren en verschillende algoritmen die NLP gebruiken om schadelijke inhoud, zoals beledigingen, bedreigingen en haatzaaiende uitlatingen in tekstgegevens, automatisch te identificeren en te classificeren.

- Samenvattend: NLP maakt het voor AI-modellen mogelijk om snel grote hoeveelheden informatie te lezen, wat een mens veel meer tijd zou hebben gekost. Identificeer vervolgens de belangrijkste delen van die tekst en presenteer deze in een samenhangende vorm. Dit bespaart een gebruiker tijd en moeite, vergroot het begrip en verbetert de besluitvorming.

- stammend: Een voorverwerkingsmethode om woorden terug te brengen tot hun basis. Helpt bij het creëren van een beter begrip van de tekst.

NLP-toepassingen in de echte wereld

Hier is een lijst met verschillende real-world toepassingen van natuurlijke taalverwerking en aanverwante technologieën.

- Chatbots houden van ChatGPT.

- Vertalers zoals AI-vertalers Engels naar Duits of Russisch naar Frans.

- Virtuele assistenten zoals Apple’s Siri, Alexa van Amazonen ChatGPT van OpenAI.

- Autocorrectiesystemen zoals Grammarly.

- Zoekmachines zoals jij.com.

- Tekstsamenvatting zoals u kunt krijgen van ChatGPT.

Uitdagingen in NLP

Hoewel de verwerking van natuurlijke taal op veel gebieden aanzienlijke vooruitgang heeft geboekt, zijn er nog steeds problemen waarmee de technologie wordt geconfronteerd. Hier zijn enkele van de belangrijkste:

- Dubbelzinnigheid en context: Menselijke talen zijn complex en inherent dubbelzinnig. Het blijft dus een zware taak voor machines om de menselijke communicatie in alle situaties volledig te begrijpen.

- Gegevens- en modelbias: AI-systemen zijn vaak bevooroordeeld, gebaseerd op de gegevens waarop ze zijn getraind. Dus hoe goed een model ook is, er is altijd sprake van enige vooringenomenheid, wat ethische bezwaren met zich meebrengt.

- Gebrek aan reden: Machines beschikken ook niet over het gezonde verstand en de redenering die mensen van nature hebben, en het implementeren ervan in een systeem kan evenzeer een lastige taak zijn.

Hulpbronnen voor het leren van NLP

- Stanford NLP-groep: https://nlp.stanford.edu/

- Coursera: https://www.coursera.org/

- DeepLearning.AI: https://www.deeplearning.ai/resources/natural-language-processing/

- Snelle datawetenschap: https://fastdatascience.com/guide-natural-language-processing-nlp/

- Kaggle: https://www.kaggle.com/

- Snelle datawetenschap: https://fastdatascience.com/guide-natural-language-processing-nlp/

- Toolkit voor natuurlijke taal: https://www.nltk.org/

- Knuffelend gezicht: https://huggingface.co/

- Wikipedia: https://en.m.wikipedia.org/wiki/Natural_language_processing

- Meesterschap in machinaal leren: https://machinelearningmastery.com/

- Geweldige NLP: https://github.com/keon/awesome-nlp

- Amazon begrijpt: https://aws.amazon.com/comprehend/

- Natuurlijke taal van Google Cloud: https://cloud.google.com/natural-language

- SpaCy: https://spacy.io/

Conclusie

Natuurlijke taalverwerking is een fascinerend gebied van kunstmatige intelligentie dat machines in staat stelt dingen te doen die decennia geleden ondenkbaar waren. Deze technologie heeft het domein van computertoepassingen uitgebreid en nieuwe markten gecreëerd.

Je hebt de vele verschillende mogelijkheden, toepassingen uit de praktijk en de beschikbare tools gezien die je kunnen helpen aan de slag te gaan met NLP. Het is echter aan u om manieren te vinden om deze te benutten bij het ontwikkelen van intelligente systemen die uw potentieel en dat van uw bedrijf zullen ontsluiten.